Regulace umělé inteligence – první legislativa svého druhu vznikla na půdě Evropské unie

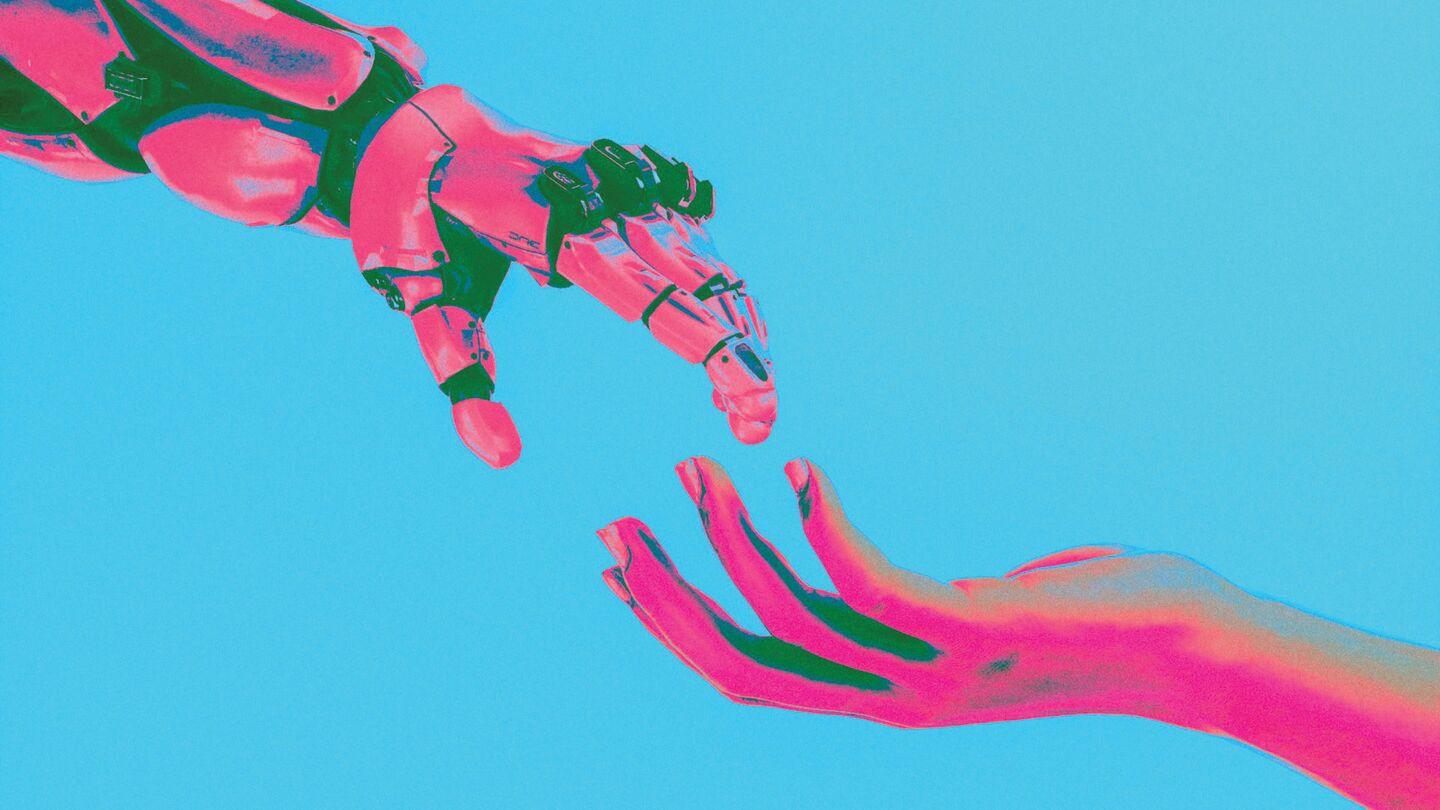

Akt o umělé inteligenci (AI Act) představuje celosvětově první komplexní soubor pravidel pro fungování umělé inteligence. Toto nařízení Evropské unie se snaží reagovat na rychlý technologický pokrok, který může každý z nás denně vnímat. Ať už jde o umělou inteligenci diagnostikující nemoci, nebezpečný deepfake nebo užitečný ChatGPT, tento předpis s nimi více či méně souvisí.

Kde se AI Act vzal?

AI Act nespadl z čistého nebe. Jednou z šesti hlavních priorit Evropské komise pro období 2019–2024 je Evropa připravená na digitální věk. V rámci této priority vzniklo v posledních letech hned několik klíčových předpisů, např. akt o digitálních trzích (DMA) nebo akt o digitálních službách (DSA). Pod tento zásadní cíl – připravit Evropu na digitální věk, kdy se přesouvá čím dál více lidské činnosti do online prostoru, – spadá i snaha regulovat AI.

Proč se soustředit zrovna na umělou inteligenci? Tato oblast počítačové vědy se zabývá vytvářením systémů schopných vykonávat úkoly, které by obvykle vyžadovaly lidskou inteligenci. Může jít o rozpoznávání vzorů, učení se na základě zkušeností, chápání komplexního jazyka, reakce na složité podněty nebo řešení zadaných problémů. Systémy umělé inteligence mohou být snadno nasazeny v mnoha sektorech ekonomiky a pro škálu úkolů ve společnosti. Unijní zákonodárce uznává, že jde o pro budoucnost klíčovou technologii, jež může podstatně zlepšit naše životy. Zároveň však přináší bezpečnostní rizika a etické otázky. Starý známý dobrý sluha, ale zlý pán.

Z priority nezaspat moderní digitální dobu a uvědomit si pozitivní i negativní potenciál umělé inteligence vzniká AI Act. Nařízení má podpořit vývoj této slibné technologie a tím sílu evropského jednotného trhu, ale zároveň chránit lidská práva a další v Evropě sdílené hodnoty. Jde také o ambiciózní plán nastavit celosvětový vzor pro komplexní regulaci umělé inteligence. Globální dopad se ostatně EU již povedl s GDPR, které ovlivnilo nakládání s osobními údaji i daleko za evropskými hranicemi. Stát se lídrem v regulaci umělé inteligence by EU umožnilo nastavovat globální standardy, zvyšovat důvěru v technologie a zajišťovat, že technologický pokrok bude respektovat evropské právo a etické hodnoty.

Koho a kdy se bude AI Act týkat?

Nejvíce pravidel aktu o umělé inteligenci dopadá na poskytovatele systémů umělé inteligence, dále popř. na jejich dovozce, distributory či ty, co je integrují do produktu či služby. Některá pravidla se mohou týkat i jednotlivců a koncových uživatelů. Část nařízení míří na členské státy, které musí mj. dohlédnout na vynucování nově stanovených pravidel.

K finální politické shodě na znění nařízení již došlo. V době, kdy tento článek vznikal, probíhala ze strany právníků a lingvistů finalizace textu běžně předcházející formálnímu schválení předpisu Radou EU. Očekává se, že členské státy, firmy a jednotlivci budou muset splnit většinu povinností plynoucí z nařízení někdy v průběhu roku 2026.

Jedním z klíčových aspektů aktu o umělé inteligenci je jeho extrateritoriální aplikace. Nařízení se nebude vztahovat pouze na subjekty působící v rámci EU, ale také na ty, jež se nacházejí mimo území Unie, pokud jejich produkty nebo služby vstupují na evropský trh nebo ovlivňují občany EU. To znamená, že jakákoliv firma nebo jednotlivec, který vyvíjí nebo uvádí na trh AI systémy používané v EU, bude muset splnit stejné požadavky bez ohledu na svou geografickou polohu. Například pokud by byla pravidla z aktu o umělé inteligenci už teď plně použitelná, dopadala by i na americkou společnost OpenAI a její ChatGPT ve všech případech, kdy generativní nástroj používá jakýkoliv občan v EU.

Základní princip – co je to hodnocení rizik?

Jelikož se nebezpečí spojená s různými systémy, modely a aplikacemi mohou výrazně lišit, AI Act kategorizuje umělou inteligenci do několika úrovní podle stupně rizikovosti pro společnost. Na základě této kategorizace pak stanovuje konkrétní pravidla. Takzvaný risk-based approach má být základem pro vyvážený přístup k technologii, který podporuje inovaci a zaručuje bezpečnost a práva občanů. Kategorie jsou čtyři.

Nepřijatelné riziko

Tato kategorie zahrnuje systémy umělé inteligence, jež jsou považovány za jasnou hrozbu pro základní práva a svobody jednotlivců. Příkladem je hodnocení sociálního kreditu, které by umožnilo vládám nebo jiným entitám evaluovat občany na základě jejich chování nebo jiných osobních charakteristik. Tento systém používá např. Čína, občanům přiděluje nebo odebírá body podle jejich sociálního chování a dodržování zákonů. Bodové skóre může ovlivnit přístup občanů k různým službám a privilegiím, jako jsou lepší úvěrové podmínky, snazší přístup k veřejným službám nebo preferenci při přijímání do zaměstnání. Systémy AI s nepřijatelným rizikem budou v rámci EU zakázány.

Vysoké riziko

Do této kategorie spadají AI systémy jejichž používání může vést k významnému poškození zdraví, bezpečnosti, základních práv, životního prostředí, demokracie a právního státu. Patří sem např. použití umělé inteligence ve zdravotní péči, bankovnictví nebo vymáhání práva. Tyto systémy budou předmětem přísného posouzení před uvedením na trh i během celého jejich životního cyklu. Občané budou mít právo podávat na tyto systémy stížnosti a znát vysvětlení rozhodnutí, která byla na základě vysoce rizikové umělé inteligence učiněna, pokud mají dopad na jejich práva.

Omezené riziko

Sem patří AI systémy jako chatboti, po kterých bude nařízení vyžadovat jen minimální povinnosti týkající se např. transparentnosti fungování. Jde hlavně o to, aby uživatelé věděli, že interagují s umělou inteligencí, a mohli se tak informovaně rozhodnout, zda chtějí s používáním dané aplikace pokračovat.

Minimální riziko

Tato kategorie zahrnuje technologie, jako jsou videohry s prvky AI nebo antispamové filtry, jež obecně představují minimální nebo žádné riziko pro práva a bezpečnost občanů. Většina AI systémů, které jsou v současnosti v EU používány, spadá do této kategorie, na niž se většina nových pravidel nevztahuje.

Deepfake, ChatGPT, Midjourney – změní se něco u věcí, které se nás týkají?

AI Act mluví o kategoriích, hodnocení rizik či dalších obecných konceptech, jak je to však s konkrétními technologiemi, které už mnozí z nás používají, popř. na ně někdy narazili? Všechny lze do aktu o umělé inteligenci někam zařadit, často u nich však nedochází k revolučním změnám.

Deepfake je video, obrázek či nahrávka, pro jejichž tvorbu autor použil generativní umělou inteligenci a které mají napodobovat realitu, ale záměrně klamou. Jde např. o falešné reklamy, kde známé osobnosti doporučují investiční nástroje, nebo o fotku papeže v obrovské péřové bundě bílé barvy. AI Act klade důraz na prevenci a ukládá tvůrcům povinnost jasně označovat umělý původ deepfaků. Tímto opatřením se nařízení snaží zvýšit povědomí o použitých technologiích a chránit veřejnost před manipulací.

Vzbuzuje však pochybnost, zda se opatřením budou řídit tvůrci deepfaků, kteří často záměrně páchají trestnou činnost. Případy, kdy autor deepfaku svůj výtvor neoznačí, AI Act už nijak neřeší. V tomto případě však mohou pomoci již existující právní předpisy. Tvorbu a následné šíření deepfaku lze např. stíhat jako podvod, poškození cizích práv nebo šíření poplašné zprávy.

ChatGPT a Midjourney jsou příklady nástrojů generativní umělé inteligence, první využívá veřejnost převážně pro práci s textem, druhý pro tvorbu obrázků a grafiky. Ohledně používání generativních modelů existují mnohé mýty, nejasnosti či dohady. Je vygenerovaný text můj, můžu ho používat a chrání mě autorské právo před tím, aby mi jej někdo ukradl? Nevykradl jsem naopak já někoho, protože bůh ví, na čem se nástroj trénoval? Můžu použít výstup nástroje ke komerčním účelům? Toto je příklad často kladených otázek, jež však AI Act sám o sobě neřeší. Odpovědi na ně je třeba hledat např. v autorském právu nebo ve smluvních podmínkách jednotlivých nástrojů.

AI Act se však věnuje kategorii GPAI (General Purpose Artificial Intelligence). Sem spadá GPT, velký jazykový model, který využívá ke svému fungování ChatGPT. Akt ukládá autorům GPAI systémů nové povinnosti, např. poskytování technické dokumentace nebo publikování informací o použitých tréninkových datech. Neočekává se však, že by tyto změny měly výrazně změnit fungování např. právě nástroje ChatGPT.

Co si z toho odnést?

AI Act je právní předpis, jehož potřebnost logicky vyplývá ze snahy přizpůsobit Evropu digitální éře a vývoji revolučních technologií založených na umělé inteligenci. Jeho podoba už je s největší pravděpodobností finální a členské státy, společnosti i jednotlivci se budou muset většinou nových pravidel řídit od zhruba poloviny roku 2026. Základní princip nařízení stojí na hodnocení rizikovosti různých AI systémů, ze kterého vychází odstupňování na nich dopadajících pravidel, popř. jejich úplné zakázání.

Přestože je AI Act nejkomplexnější předpis týkající se umělé inteligence na světě, některých známých nástrojů či postupů se týká jen okrajově. Tento článek ukazuje na příkladech jako deepfake nebo ChatGPT, že jejich podstatu neřeší nebo nemění, a odpovědi na četné otázky, které je obkopují, již teď poskytují jiné zákony.

Naopak velký důraz AI Act klade na obranu takových hodnot jako lidská práva, bezpečnost, demokracie či právní stát. Jen těžko by se za tuto snahu dal evropský zákonodárce kritizovat. Na druhé straně však stojí tvůrci umělé inteligence, kterým další regulace ztíží vývoj a potenciálně zpomalí inovační proces. Zda se povedlo Evropské unii vybalancovat ochranu hodnot na straně jedné a podporou technologického pokroku na straně druhé, to ukáže čas.

→ Lucie Malá vystudovala mezinárodní a evropské právo na University of Groningen v Nizozemsku, momentálně studuje na Právnické fakultě Univerzity Karlovy a působí v advokátní kanceláři Legitas, kde se věnuje IT právu.